Java操作es插入数据后,立即查询没结果解决办法

解决办法

原因:ES默认不执行刷新操作,需要手动设置参数才能在更新文档后立即刷新。

从以下源码中可以看出刷新策略有三种: NONE(“false”)、IMMEDIATE(“true”)、WAIT_UNTIL(“wait_for”)

public static enum RefreshPolicy implements Writeable {

/**

*请求向Elasticsearch提交了数据,不进行数据刷新,直接结束请求。

*这种策略的优点是资源消耗低、写入性能高,缺点是实时性低、数据安全性差。

**/

NONE("false"),

/**

*请求向Elasticsearch提交了数据,立即进行数据刷新,然后再结束请求。

*这种策略的优点是实时性高、操作延时短,缺点是资源消耗高。

**/

IMMEDIATE("true"),

/**

*请求向Elasticsearch提交了数据,等待数据完成刷新,然后再结束请求。

*这种策略的优点是实时性和资源消耗之间有一个平衡,缺点是操作延时较长。

**/

WAIT_UNTIL("wait_for");

private final String value;

private RefreshPolicy(String value) {

this.value = value;

}

public String getValue() {

return this.value;

}

public static WriteRequest.RefreshPolicy parse(String value) {

WriteRequest.RefreshPolicy[] var1 = values();

int var2 = var1.length;

for(int var3 = 0; var3 < var2; ++var3) {

WriteRequest.RefreshPolicy policy = var1[var3];

if (policy.getValue().equals(value)) {

return policy;

}

}

if ("".equals(value)) {

return IMMEDIATE;

} else {

throw new IllegalArgumentException("Unknown value for refresh: [" + value + "].");

}

}

public static WriteRequest.RefreshPolicy readFrom(StreamInput in) throws IOException {

return values()[in.readByte()];

}

public void writeTo(StreamOutput out) throws IOException {

out.writeByte((byte)this.ordinal());

}

}具体操作

request.setRefreshPolicy(WriteRequest.RefreshPolicy.IMMEDIATE);//插入完成后立即强制刷新索引具体位置

//单条增加

IndexRequest request = new IndexRequest();

request.setRefreshPolicy(WriteRequest.RefreshPolicy.IMMEDIATE);

//后面省略。。。。。

//批量增加

BulkRequest bulkRequest = new BulkRequest();

bulkRequest.setRefreshPolicy(WriteRequest.RefreshPolicy.IMMEDIATE);

//同上es写入流程

elasticsearch写入数据时涉及到的核心概念讲解:

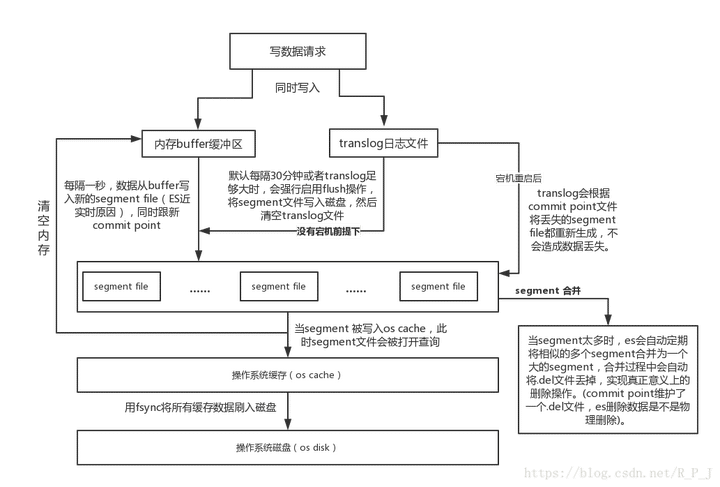

segment file: 存储倒排索引的文件,每个segment本质上就是一个倒排索引,每秒都会生成一个segment文件,当文件过多时es会自动进行segment merge(合并文件),合并时会同时将已经标注删除的文档物理删除;

commit point(重点理解): 记录当前所有可用的segment,每个commit point都会维护一个.del文件(es删除数据本质是不属于物理删除),当es做删改操作时首先会在.del文件中声明某个document已经被删除,文件内记录了在某个segment内某个文档已经被删除,当查询请求过来时在segment中被删除的文件是能够查出来的,但是当返回结果时会根据commit point维护的那个.del文件把已经删除的文档过滤掉;

translog日志文件: 为了防止elasticsearch宕机造成数据丢失保证可靠存储,es会将每次写入数据同时写到translog日志中(图中会有详解)。

完整elasticsearch的写入数据流程如下:

refresh

es接收数据请求时先存入内存中,默认每隔一秒会从内存buffer中将数据写入filesystem cache,这个过程叫做refresh;(在这时候查询是查不到的)

fsync

translog会每隔5秒或者在一个变更请求完成之后执行一次fsync操作,将translog从缓存刷入磁盘,这个操作比较耗时,如果对数据一致性要求不是跟高时建议将索引改为异步,如果节点宕机时会有5秒数据丢失;

flush

es默认每隔30分钟会将filesystem cache中的数据刷入磁盘同时清空translog日志文件,这个过程叫做flush。